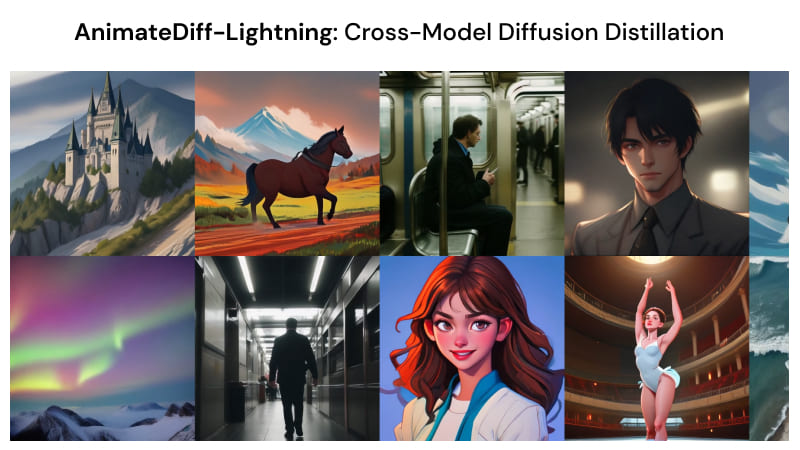

AnimateDiff-Lightning是什么

AnimateDiff-Lightning是由字节跳动的研究人员最新推出的一个高质量视频生成模型,利用了渐进式对抗性扩散蒸馏技术来实现快速的视频生成。该模型旨在解决现有视频生成模型在速度和计算成本上的主要挑战,同时保持生成视频的高质量,相较于原始的 AnimateDiff,生成视频的速度快十倍以上!

AnimateDiff-Lightning的官网入口

- Hugging Face模型地址:https://huggingface.co/ByteDance/AnimateDiff-Lightning

- Hugging Face Demo运行:https://huggingface.co/spaces/AP123/AnimateDiffLightning

- arXiv研究论文:https://arxiv.org/html/2403.12706v1

AnimateDiff-Lightning的功能特性

- 快速视频生成:AnimateDiff-Lightning能够通过少步骤推断(few-step inference)快速生成视频,显著减少了视频生成所需的时间,使其适用于需要即时或快速内容生成的场景。

- 高质量输出:尽管生成速度快,AnimateDiff-Lightning仍然能够保持视频内容的高质量,确保生成的视频在视觉上具有较高的清晰度和细节表现。

- 风格兼容性:通过跨模型蒸馏技术,AnimateDiff-Lightning能够适应多种不同的基础模型,这意味着它可以生成具有不同艺术风格(如现实主义、动漫、卡通等)的视频内容。

- 不同宽高比的视频生成:AnimateDiff-Lightning能够在不同的宽高比下生成视频,支持多种视频格式和布局要求。

- 视频到视频的转换:AnimateDiff-Lightning不仅支持从文本到视频的生成,还能够进行视频到视频的风格转换,为用户提供高度的创作自由度。

- 与控制模块的兼容性:AnimateDiff-Lightning可以与图像控制模块(如ControlNet)和相机运动模块(如Motion LoRA)结合使用,进一步增强视频内容的控制能力。

AnimateDiff-Lightning的工作原理

AnimateDiff-Lightning的方法是基于AnimateDiff模型的改进,并通过跨模型扩散蒸馏技术来提高视频生成的速度和质量。以下是AnimateDiff-Lightning方法的关键步骤和组成部分:

1. 模型和数据准备

- 选择基础模型:AnimateDiff-Lightning选择了多个流行的基础模型,包括现实风格和动漫风格的模型,如Stable Diffusion v1.5、RealisticVision v5.1、epiCRealism、ToonYou Beta 6、IMP v1.0和Counterfeit v3.0。

- 数据生成:使用AnimateDiff模型和选定的基础模型生成大量的视频剪辑数据,以支持蒸馏过程。这些数据包括从WebVid-10M数据集生成的现实风格视频和使用文本提示生成的动漫风格视频。

2. 跨模型蒸馏

- 共享运动模块:AnimateDiff模型由冻结的图像基础模型和共享的运动模块组成。在蒸馏过程中,只更新运动模块的权重,而保持图像基础模型的权重不变。

- 多GPU训练:在不同的GPU上加载不同的图像基础模型,并初始化相同的运动模块。这样可以同时在多个基础模型上进行蒸馏,提高了训练效率。

3. 流条件视频判别器

- 扩展判别器:为了处理多个基础模型的不同流动,判别器被扩展为流条件的,即它可以根据基础模型的索引来学习并评估不同的流动轨迹。

- 训练判别器:判别器与扩散模型和蒸馏模型一起训练,以确保生成的视频在风格和质量上与原始模型相匹配。

4. 蒸馏过程

- 渐进式蒸馏:AnimateDiff-Lightning按照128 → 32 → 8 → 4 → 2的步骤顺序进行蒸馏,使用均方误差(MSE)和分类器自由引导(CFG)进行初步蒸馏,然后使用对抗性损失进行后续步骤。

- 梯度累积:由于GPU内存限制,每个GPU只能处理一个批次,因此使用梯度累积技术来实现较大的有效批次大小。

5. 评估和测试

- 定性评估:通过与原始AnimateDiff和AnimateLCM模型的比较,展示AnimateDiff-Lightning在不同推断步骤下生成视频的质量。

- 定量评估:使用FVD(Fréchet Video Distance)指标对不同基础模型上生成的视频进行定量比较,以证明AnimateDiff-Lightning在保持原始质量方面的优势。